Através de um comunicado de imprensa, a OpenAI anunciou novos modelos e atualizações de API. Confira os detalhes dessa novidade.

Sim. A OpenAI emitiu recentemente um comunicado de imprensa que confirma a atualização de seu modelo de pré-visualização GPT-4 Turbo. No comunicado, a empresa também otimizou o desempenho dos modelos existentes e lançou um novo modelo embarcado.

OpenAI anunciou novos modelos e atualizações de API

O lançamento e a atualização incluem dois modelos de incorporação de texto, uma visualização atualizada do GPT-4 Turbo, uma atualização do GPT-3.5 Turbo e um modelo de auditoria.

Com base no feedback do desenvolvedor sobre a versão de visualização inicial, a OpenAI lançou o modelo de visualização gpt-4-0125-preview. Este modelo se concentra em corrigir o carregamento “lento” do modelo para concluir tarefas de forma mais completa, como geração de código.

A nova visualização também melhora o suporte para problemas gerados em idiomas diferentes do inglês e introduz um alias de modelo “gpt-4-turbo-preview” que aponta automaticamente para a visualização mais recente.

A OpenAI também planeja lançar totalmente o GPT-4 Turbo com recursos de visão nos próximos meses.

Novo modelo incorporado com preços mais baixos

OpenAI também introduz dois novos modos de incorporação, um é um modelo menor e mais eficiente, o text-embedding-3-small, e o outro é um modelo maior e mais poderoso, o text-embedding-3-large.

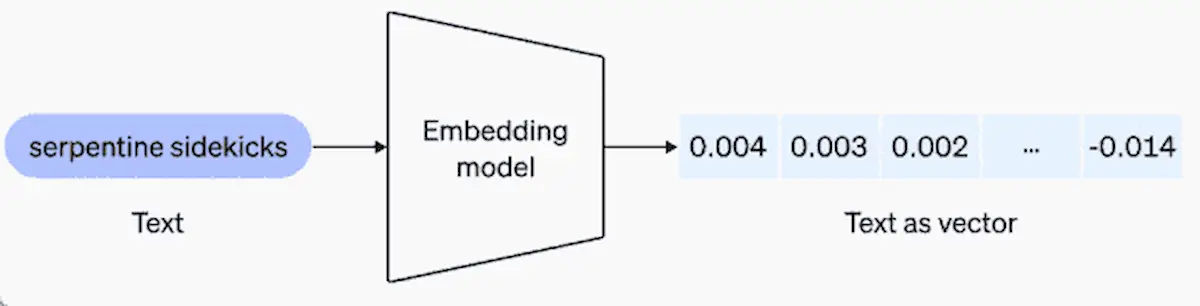

Uma incorporação é uma sequência de números que representa um conceito em algo como linguagem natural ou código.

A incorporação torna mais fácil para modelos de aprendizado de máquina e outros algoritmos entenderem como o conteúdo está relacionado e executar tarefas como clustering ou recuperação.

Aplicativos como recuperação de conhecimento em ChatGPT e API de assistentes, bem como muitas ferramentas de desenvolvimento de geração de aumento de recuperação (RAG), usam o conceito de incorporação.

Text-embedding-3-small

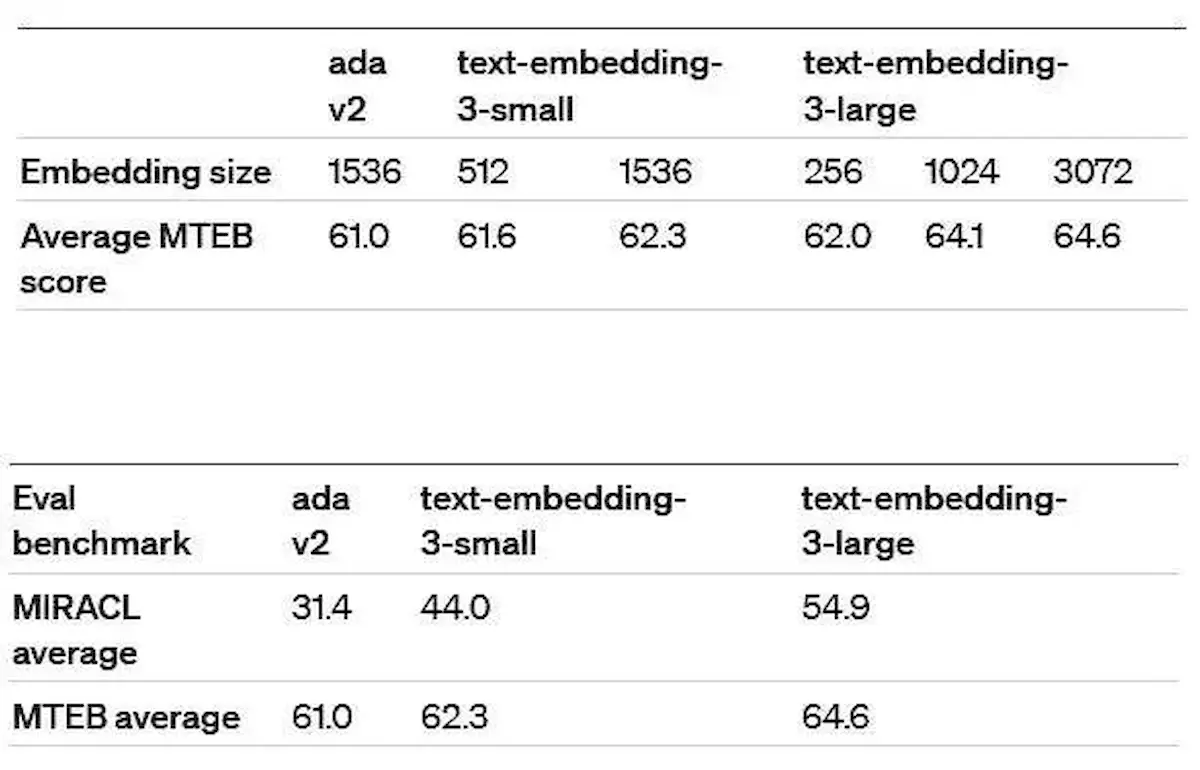

Em comparação com o modelo text-embedding-ada-002 lançado em dezembro de 2022, o desempenho e a eficiência do text-embedding-3-small foram bastante melhorados.

Em termos de desempenho, a pontuação média de text-embedding-3-small no Multilingual Retrieval Common Benchmark (MIRACL) aumentou de 31,4% para 44,0%. A pontuação média no Common English Task Benchmark (MTEB) aumentou de 61,0% para 62,3%.

Em termos de preço, o preço de text-embedding-3-small é um quinto do de text-embedding-ada-002, caindo de US$ 0,0001 por token de 1k para US$ 0,00002.

Text-embedding-3-large

Text-embedding-3-large é o novo modelo de melhor desempenho lançado pela OpenAI. Comparando text-embedding-ada-002 com text-embedding-3-large: no MIRACL, a pontuação média melhora de 31,4% para 54,9%. Porém, no MTEB, a pontuação média melhora de 61,0% para 64,6%. Text-embedding-3-large custa US$ 0,00013 por mil tokens.

Suporte nativo para encurtamento

O suporte nativo para encurtamento permite que os desenvolvedores troquem requisitos mais baixos de armazenamento e computação por um certo nível de precisão. Simplificando, encurtar é como remover alguns detalhes menos importantes de um rótulo complexo, mantendo a essência.

GPT-3.5 Turbo

No campo API, o GPT-3.5 Turbo também tem um bom desempenho. Ao realizar diversas tarefas, ele não só oferece custo menor que o GPT-4, mas também garante velocidade de execução mais rápida.

Portanto, para os utilizadores pagantes, a redução de 50% nos preços dos factores de produção e de 25% nos preços dos produtos é, sem dúvida, um grande benefício.

Especificamente, o novo preço de entrada é fixado em US$ 0,0005 por token de 1 mil, enquanto o preço de saída é fixado em US$ 0,0015 por token de 1 mil.

O recente comunicado de imprensa da OpenAI anuncia avanços significativos em seus modelos e serviços de IA.

A atualização para o modelo de visualização GPT-4 Turbo atende aos comentários dos desenvolvedores, com foco na melhoria do desempenho e no suporte a idiomas, especialmente para contextos que não sejam o inglês.

Além disso, a introdução de novos modelos incorporados, incluindo text-embedding-3-small e text-embedding-3-large, apresenta melhorias na eficiência e nas métricas de desempenho, como pontuações MIRACL e MTEB.

O suporte nativo para encurtamento oferece aos desenvolvedores flexibilidade no equilíbrio entre precisão e requisitos de recursos.

Além disso, a otimização do GPT-3.5 Turbo traz soluções econômicas com preços de entrada e saída reduzidos, atendendo às necessidades dos usuários pagantes e garantindo uma execução mais rápida.

No geral, essas atualizações ressaltam o compromisso da OpenAI em aprimorar os recursos e a acessibilidade da IA.