Ao revelar o framework NVIDIA NeMo Megatron e sua disponibilidade, a NVIDIA traz os modelos de IA de grande porte para empresas no mundo.

NVIDIA abriu a porta para empresas em todo o mundo desenvolverem e implantarem modelos de grande linguagem (LLM), permitindo-lhes construir seus próprios chatbots específicos de domínio, assistentes pessoais e outros aplicativos de IA que entendem a linguagem com níveis sem precedentes de sutileza e nuance.

NVIDIA traz os modelos de IA de grande porte para empresas no mundo

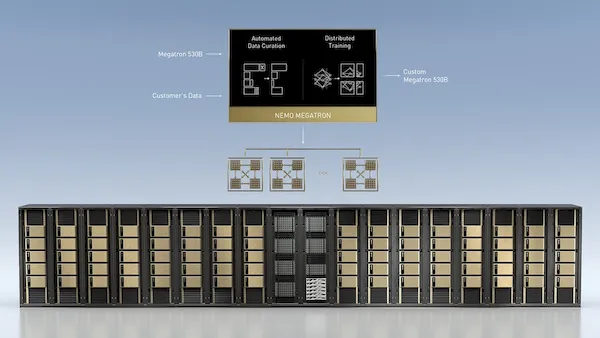

A empresa revelou o framework NVIDIA NeMo Megatron para treinar modelos de linguagem com trilhões de parâmetros, o Megatron 530B LLM personalizável que pode ser treinado para novos domínios e idiomas, e NVIDIA Triton Inference Server ™ com funcionalidade de inferência distribuída multi-GPU e multinó.

Combinado com os sistemas NVIDIA DGX ™, essas ferramentas fornecem uma solução de nível empresarial pronta para produção para simplificar o desenvolvimento e implantação de grandes modelos de linguagem.

Bryan Catanzaro, vice-presidente da Applied Deep Pesquisa de aprendizagem na NVIDIA, disse:

“Grandes modelos de linguagem provaram ser flexíveis e capazes, capazes de responder a questões de domínio profundo, traduzir idiomas, compreender e resumir documentos, escrever histórias e programas de computação, tudo sem treinamento especializado ou supervisão. Construir grandes modelos de linguagem para novos idiomas e domínios é provavelmente a maior aplicação de supercomputação até agora, e agora esses recursos estão ao alcance das empresas do mundo todo.”

Desenvolvimento NVIDIA NeMo Megatron e Megatron 530B Speed LLM

NVIDIA NeMo Megatron baseia-se nos avanços do Megatron, um projeto de código aberto liderado por pesquisadores da NVIDIA que estudam o treinamento eficiente de grandes modelos de linguagem de transformadores em escala. Megatron 530B é o maior modelo de linguagem personalizável do mundo.

A estrutura NeMo Megatron permite que as empresas superem os desafios de treinar modelos sofisticados de processamento de linguagem natural. Ele é otimizado para escalar horizontalmente em toda a infraestrutura de computação acelerada de grande escala do NVIDIA DGX SuperPOD ™.

NeMo Megatron automatiza a complexidade do treinamento LLM com bibliotecas de processamento de dados que ingerem, selecionam, organizam e limpam dados.

Usando tecnologias avançadas para paralelização de dados, tensor e pipeline, ele permite o treinamento de grandes modelos de linguagem para serem distribuídos de forma eficiente em milhares de GPUs.

As empresas podem usar a estrutura NeMo Megatron para treinar LLMs para seus domínios e idiomas específicos.

Servidor de inferência NVIDIA Triton ativa a inferência LLM em tempo real

Os novos recursos multi-GPU e multinó do mais recente NVIDIA Triton Inference Server – anunciados separadamente hoje – permitem que as cargas de trabalho de inferência LLM sejam escalonadas em várias GPUs e nós com desempenho em tempo real.

Os modelos requerem mais memória do que está disponível em uma única GPU ou mesmo em um grande servidor com várias GPUs, e a inferência deve ser executada rapidamente para ser útil nos aplicativos.

Com o Triton Inference Server, o Megatron 530B pode ser executado em dois sistemas NVIDIA DGX para reduzir o tempo de processamento de mais de um minuto em um servidor CPU para meio segundo, tornando possível implantar LLMs para aplicativos em tempo real.

Modelos de linguagem personalizados massivos desenvolvidos em todo o mundo

Entre os primeiros a criar modelos de grande linguagem com NVIDIA DGX SuperPOD estão SiDi, JD Explore Academy e VinBrain.

O SiDi, um dos maiores institutos de pesquisa e desenvolvimento de IA do Brasil, adaptou o assistente virtual Samsung para uso pelos 200 milhões de falantes do português brasileiro.

Sobre isso, John Yi, CEO da SiDi, disse:

“A equipe da SiDi tem ampla experiência no desenvolvimento de assistentes virtuais de IA e chatbots, que exigem desempenho de IA poderoso e software especializado que é treinado e adaptado às mudanças nas nuances da linguagem humana. NVIDIA DGX SuperPOD é ideal para impulsionar o trabalho avançado de nossa equipe para nos ajudar a trazer serviços de IA líderes mundiais para falantes de português no Brasil.”

A JD Explore Academy, a divisão de pesquisa e desenvolvimento da JD.com, uma provedora líder de serviços e tecnologia baseada em cadeia de suprimentos, está utilizando NVIDIA DGX SuperPOD para desenvolver PNL para a aplicação de atendimento ao cliente inteligente, varejo inteligente, logística inteligente, IoT, saúde e mais.

VinBrain, uma empresa de IA de saúde com base no Vietnã, usou um DGX SuperPOD para desenvolver e implantar um modelo de linguagem clínica para radiologistas e telessaúde em 100 hospitais, onde é usado por mais de 600 profissionais de saúde.

Disponibilidade

As empresas podem desenvolver e implantar grandes modelos de linguagem gratuitamente em laboratórios com curadoria com NVIDIA LaunchPad, anunciado separadamente hoje.

As organizações podem se inscrever para participar do programa de acesso antecipado para a estrutura acelerada NVIDIA NeMo Megatron para o treinamento de grandes modelos de idiomas.

NVIDIA Triton está disponível no catálogo NVIDIA NGC ™, um hub para software de IA otimizado para GPU que inclui frameworks, kits de ferramentas, modelos pré-treinados e Jupyter Notebooks, e como código-fonte aberto do repositório Triton GitHub.

O Triton também está incluído no pacote de software NVIDIA AI Enterprise, que é otimizado, certificado e suportado pela NVIDIA. As empresas podem usar o pacote de software para executar inferência de modelo de linguagem em servidores acelerados convencionais em data centers locais e nuvens privadas.

Os sistemas NVIDIA DGX SuperPOD e NVIDIA DGX estão disponíveis nos revendedores globais da NVIDIA, que podem fornecer preços para clientes qualificados mediante solicitação.